Themen & Trends – der CCW Blog für innovativen Kundendialog

© Management Circle AG 2024

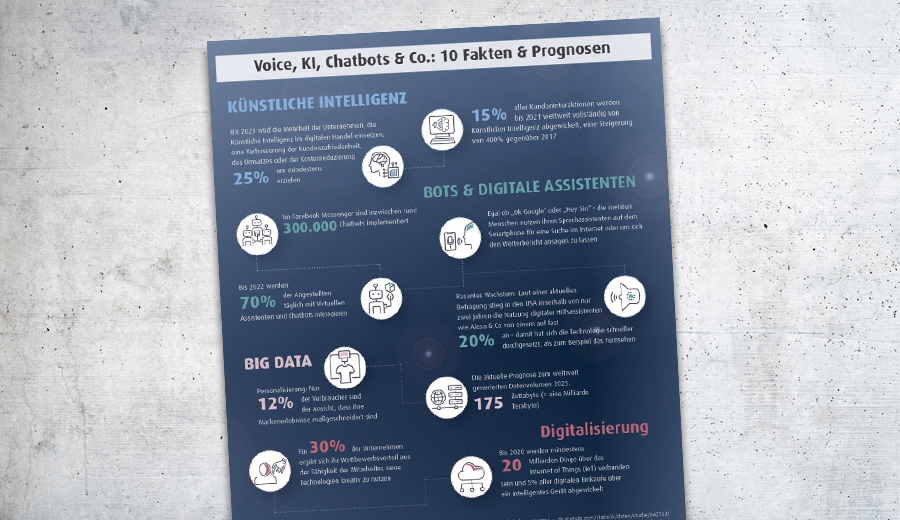

Lesen Sie, an welchen neuen Stellschrauben Sie drehen können, um ihren Kundenservice zukunftsfähig aufzustellen. Wir haben die wichtigsten Customer Service-Trends kompakt für Sie zusammengefasst.

Kostenloser Download: Rückblick zur CCW 2023